Забавная «галлюцинация» языковой нейросети обнаружилась уже в 22-х научных статьях

С недавних пор ученые стали натыкаться на странный термин в научных публикациях: «вегетативная электронная микроскопия». Эта фраза, которая звучит наукообразно, но на самом деле не имеет смысла, стала ошибкой, которая зафиксировалась и усиливается в системах искусственного интеллекта и практически не поддается удалению оттуда. Подобно биологическим окаменелостям, затерянным в скале, эти цифровые артефакты могут стать постоянными элементами нашего информационного пространства, пишут ученые из Квинслендского технологического университета (Австралия) в Сonversation.

По данным Google Scholar, «вегетативная электронная микроскопия» уже встречается в 22 работах. На наличие термина в работах издатели реагировали по-разному: некоторые удалили статьи, другие защищали их. Словосочетание, например, стало причиной спорного отзыва публикации из журнала Springer Nature, а Elsevier выпустил исправление по поводу своей публикации.

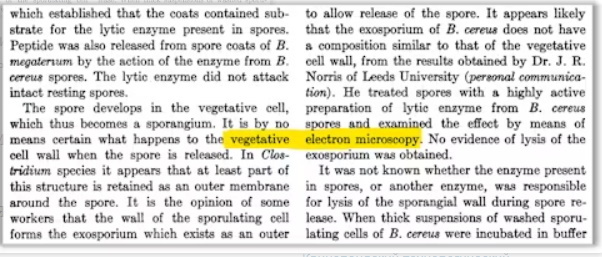

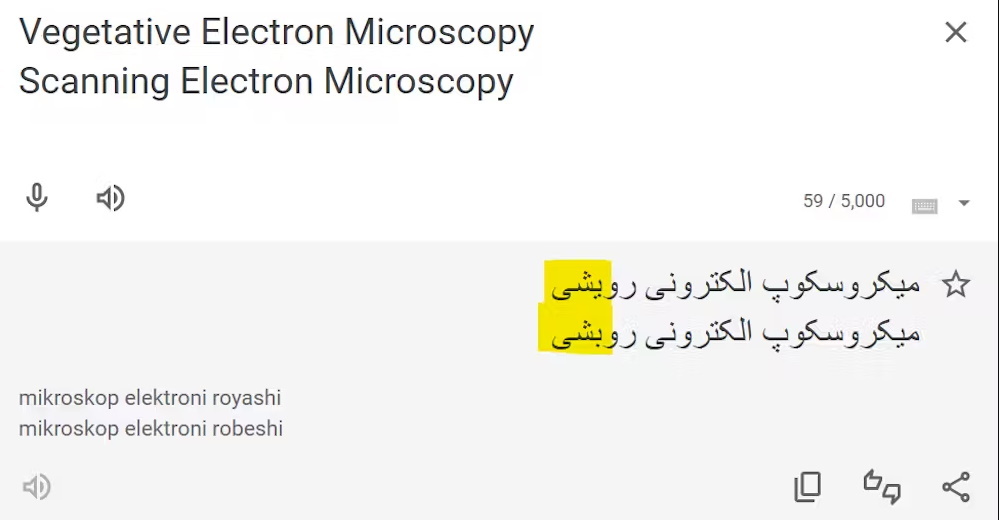

Случай с «вегетативной электронной микроскопией» демонстрирует, как системы ИИ могут поддерживать и усиливать ошибки. Термин возник благодаря удивительному совпадению несвязанных ошибок. При оцифровке научного журнала 1950-х годов процесс распознавания неверно соединил слово «vegetative» из одного столбца с «electron» из другого, создав призрачный термин. В конце 2010-х годов термин появился в иранских научных работах — вероятно из-за ошибки перевода, так как на фарси слова «vegetative» и «scanning» (сканирующая) отличаются всего одной точкой.

Современные языковые модели, обученные на массиве научных статей, запомнили этот термин и продолжают распространять его. Выяснилось, что ошибка распространяется в GPT-4 и Claude 3.5 от Anthropic.

Удалить такие ошибки чрезвычайно сложно. Во-первых, из-за огромных объемов данных: например, набор CommonCrawl — это миллионы гигабайт. Также, компании не предоставляют точной информации о наборах данных, на которых тренировались их модели.

Эти «цифровые окаменелости» вызывают вопросы, когда ИИ все чаще используется в исследованиях и написании текстов вообще. Исследователи должны находить способы оценки новой информации в эпоху генеративного ИИ.