Генеративный ИИ может «сломать» интернет

Генеративные модели искусственного интеллекта, такие как GPT-4o от OpenAI или Stability AI от Stable Diffusion, способны создавать новый текст, код, изображения и видео. Однако для обучения нейросетей требуются такие огромные объемы данных, что разработчики уже сталкиваются с ограничениями и вскоре могут полностью исчерпать ресурсы для обучения.

На фоне дефицита данных разработчики могут обратиться к искусственным данным. Синтезированные ИИ данные дешевле «живых», и практически безграничны по объему. Здесь нет рисков для конфиденциальности, в отличие, например, от медицинской информации. В некоторых случаях синтетические данные могут даже улучшить работу ИИ.

Однако недавно ученые из Университета Райса выяснили, что скармливание моделям ИИ синтетических данных оказывает серьезное негативное влияние. Проблемы возникают, когда обучение на синтетических данных неизбежно повторяется, образуя своего рода петлю обратной связи, отмечает Ричард Баранюк, профессор электротехники и вычислительной техники Университета Райса.

«Наша группа много работала над такими петлями обратной связи, и плохая новость заключается в том, что даже после нескольких поколений такого обучения новые модели могут стать непоправимо испорченными. Кто-то называет это крахом, однако мы предпочитаем использовать термин "расстройство модельной аутофагии" (MADness)», — говорит Баранюк.

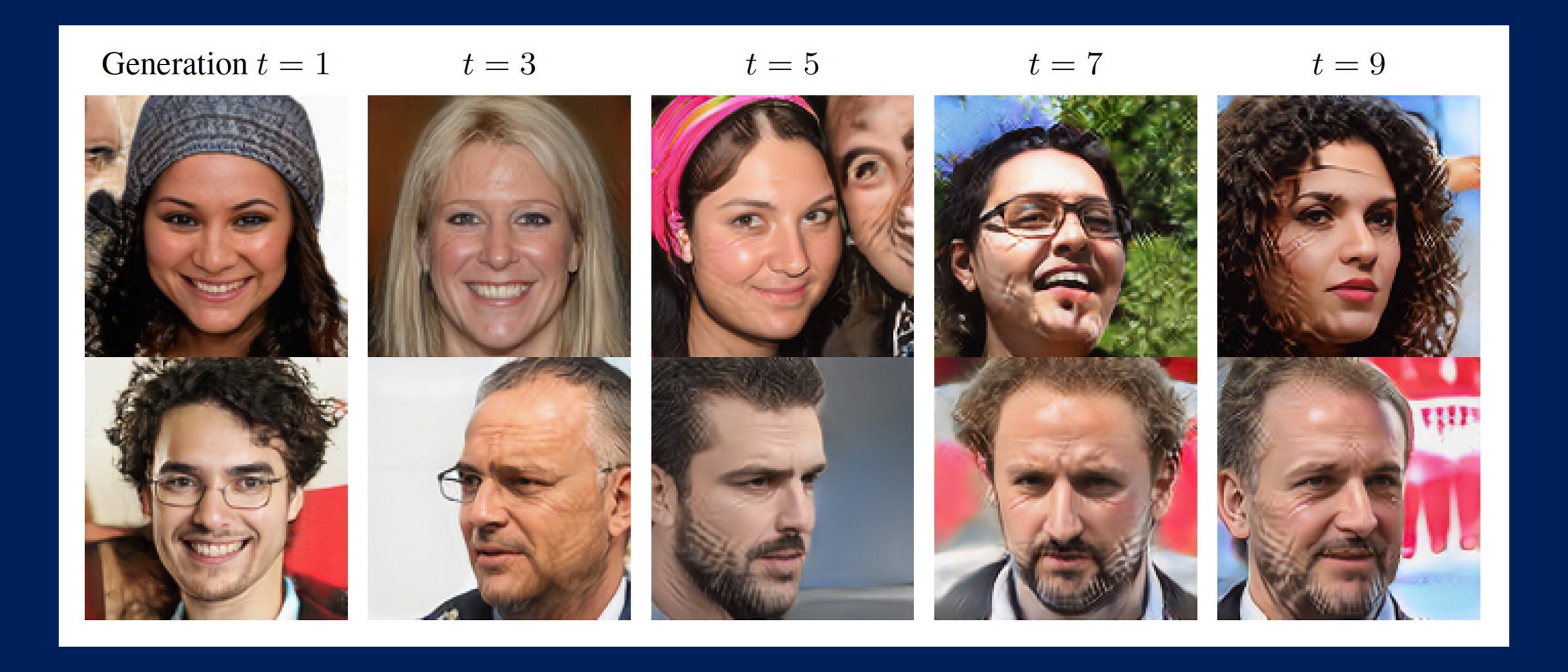

Исследователи изучили работу с визуальными моделями ИИ, чтобы лучше подчеркнуть недостатки аутофагического обучения, но те же проблемы возникают и с языковыми моделями. Источником обучающих наборов данных для генеративных моделей ИИ обычно становится интернет, поэтому по мере распространения синтетических данных в сети с каждым новым поколением модели могут возникать саморазрушающиеся циклы. Чтобы получить представление о различных сценариях развития событий, Баранюк и его команда изучили три варианта самопоглощающих циклов: полностью синтетический цикл, цикл синтетического дополнения и цикл «Свежие данные».

Полностью синтетический цикл — последующие поколения ИИ используют для обучения полностью синтетические данные, отобранные из результатов предыдущих поколений. Цикл синтетического дополнения — набор обучающих данных для каждого поколения модели включает в себя комбинацию синтетических данных, отобранных из предыдущих поколений, и фиксированный набор «живых» обучающих данных. В цикле «Свежие данные» каждое поколение модели обучается на комбинации синтетических данных из предыдущих поколений и свежем наборе реальных обучающих данных.

Прогрессивные повторения циклов показали, что со временем и в отсутствие достаточного количества свежих реальных данных модели генерируют все более искаженные результаты, лишенные либо качества, либо разнообразия, либо того и другого. Другими словами, чем больше свежих данных, тем здоровее ИИ.

Сравнение наборов данных изображений, полученных в результате смены поколений модели, рисует жуткую картину потенциального будущего ИИ. Наборы данных, состоящие из человеческих лиц, становятся все более испещренными шрамами, похожими на сетку, либо все больше похожими на одного и того же человека. Наборы данных, состоящие из чисел, превращаются в неразборчивые каракули.

«Некоторые последствия очевидны: без достаточного количества свежих реальных данных будущие генеративные модели обречены на провал», — отмечает Баранюк. По его словам, есть даже один из сценариев конца света, при котором модельная аутофагия остается без контроля на протяжении поколений, и портит качество и разнообразие данных во всем интернете. Если такого не случится, все равно в результате аутофагии ИИ могут возникнуть непредвиденные последствия — даже в ближайшей перспективе.