Физика в нейросетях: объявлены лауреаты Нобелевской премии 2024 года

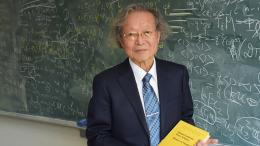

Нобелевская премия по физике 2024 года присуждена Джону Хопфилду (Принстонский университет) и Джеффри Хинтону (Университет Торонто) «за основополагающие открытия и изобретения, которые позволяют осуществлять машинное обучение с использованием искусственных нейронных сетей».

Хотя компьютеры не могут думать, машины теперь могут имитировать такие функции, как память и обучение. Лауреаты этого года по физике помогли сделать это возможным. Используя фундаментальные концепции и методы из физики, они разработали технологии, которые используют структуры в сетях для обработки информации.

Машинное обучение отличается от традиционного программного обеспечения, которое работает как своего рода рецепт. В машинном же обучении компьютер учится на примерах, что позволяет ему решать проблемы, которые слишком расплывчаты и сложны для управления пошаговыми инструкциями. Одним из примеров является интерпретация изображения для идентификации объектов на нем.

Лауреаты Нобелевской премии по физике этого года использовали инструменты физики для разработки методов, которые стали основой современного мощного машинного обучения. Джон Хопфилд создал ассоциативную память, которая может хранить и восстанавливать изображения и другие типы шаблонов в данных. Джеффри Хинтон изобрел метод, который может автономно находить свойства в данных и таким образом выполнять такие задачи, как идентификация определенных элементов на изображениях.

Когда мы говорим об искусственном интеллекте, часто подразумеваем машинное обучение с использованием искусственных нейронных сетей. Эта технология изначально была вдохновлена структурой мозга. В искусственной нейронной сети нейроны мозга можно представить узлами, которые имеют разные значения. Эти узлы влияют друг на друга через связи (их можно сравнить с синапсами), которые можно сделать сильнее или слабее. Сеть обучается, в частности, путем развития более сильных связей между узлами. Лауреаты этого года проводили важную работу с искусственными нейронными сетями с 1980-х годов.

Джон Хопфилд изобрел сеть, которая использует метод сохранения и воссоздания узоров. Мы можем представить узлы как пиксели. Сеть Хопфилда использует физику, которая описывает характеристики материала по его атомному спину — свойству, которое делает каждый атом крошечным магнитом. Сеть в целом описывается способом, эквивалентным энергии в спиновой системе, и обучается путем поиска связей между узлами. Когда сети Хопфилда подается искаженное или неполное изображение, она методично прорабатывает узлы и обновляет их значения. Таким образом, сеть работает поэтапно, чтобы найти сохраненное изображение, которое больше всего похоже на представленное ей испорченное.

Джеффри Хинтон использовал сеть Хопфилда в качестве основы для новой сети, которая использует другой метод: машину Больцмана. Она может научиться распознавать характерные элементы в заданном типе данных. Хинтон использовал инструменты из статистической физики — науки о системах, построенных из множества схожих компонентов. Машину Больцмана можно использовать для классификации изображений или создания новых примеров типа шаблона, на котором она была обучена. Хинтон развил эту работу, помогая инициировать текущее взрывное развитие машинного обучения.

«Работа лауреатов уже принесла огромную пользу. В физике мы используем искусственные нейронные сети в широком спектре областей, таких как разработка новых материалов с определенными свойствами», — говорит Эллен Мунс, председатель Нобелевского комитета по физике.

Имитация мозга

Искусственная нейронная сеть обрабатывает информацию, используя всю структуру сети. Первоначально вдохновение пришло из желания понять, как работает мозг. В 1940-х годах исследователи начали рассуждать о математике, лежащей в основе нейронной сети и синапсов мозга. Другая часть головоломки пришла из психологии благодаря гипотезе нейробиолога Дональда Хебба о том, как происходит обучение, поскольку связи между нейронами усиливаются, когда они работают вместе.

Позже эти идеи были продолжены попытками воссоздать, как функционирует сеть мозга, путем создания искусственных нейронных сетей в качестве компьютерных симуляций. В них нейроны мозга имитируются узлами, которым присваиваются различные значения, а синапсы представлены связями между узлами, которые можно сделать сильнее или слабее. Гипотеза Дональда Хебба до сих пор используется как одно из основных правил обновления искусственных сетей с помощью процесса, называемого обучением.

Ассоциативная память

Представьте, что вы пытаетесь вспомнить довольно необычное слово, перебирая в голове похожие. Этот процесс напоминает ассоциативную память, которую физик Джон Хопфилд создал в 1982 году. Сеть Хопфилда может хранить шаблоны и обладает методом для их воссоздания. Когда сети дается неполный или слегка искаженный шаблон, метод может найти наиболее похожий из сохраненных.

Хопфилд был очарован структурой мозга: когда нейроны действуют вместе, они могут давать новые и мощные характеристики, не очевидные, если смотреть только на отдельные компоненты сети. Он также изучал магнитные материалы, которые обладают особыми характеристиками благодаря их атомному спину — свойству, которое делает каждый атом крошечным магнитом. Спины соседних атомов влияют друг на друга; это может позволить узлам формироваться с однонаправленным спином. Он смог создать модельную сеть с узлами и связями, используя физику, которая описывает, как меняются материалы, когда спины влияют друг на друга.

Будто на местности

Сеть, которую построил Хопфилд, имеет узлы, которые соединены между собой связями разной силы. Каждый узел может хранить индивидуальное значение – в первой работе Хопфилда это могло быть либо 0, либо 1, как пиксели на черно-белом изображении.

Хопфилд описал общее состояние сети свойством, которое эквивалентно энергии в спиновой системе, позаимствованной в физике; энергия вычисляется с помощью формулы, которая использует все значения узлов и все силы связей между ними. Сеть Хопфилда программируется с помощью изображения, подаваемого на узлы, которым присваивается значение черного (0) или белого (1). Затем связи сети корректируются с помощью формулы энергии, при этом сохраненное изображение получает низкую энергию. Когда в сеть подается другое изображение, оно последовательно проходит по узлам, и проверяется снизится ли энергия, если значение узла изменяется. Если оказывается, что энергия уменьшается, черный пиксель становится белым, он меняет цвет. Эта процедура продолжается до тех пор, пока невозможно найти какие-либо дальнейшие изменения. Когда эта точка достигнута, сеть обычно воспроизводит исходное изображение, на котором она была обучена.

Это может показаться не таким уж замечательным, если вы сохраняете только один шаблон, но метод Хопфилда особенный, поскольку несколько изображений могут быть сохранены одновременно, и сеть обычно может различать их.

Хопфилд сравнил поиск сохраненного состояния с катанием мяча по ландшафту с возвышенностями и впадинами. Если мяч уронить в определенном месте, он покатится в ближайшую впадину и остановится там. Если сети дать шаблон, который близок к одному из сохраненных шаблонов, она, таким же образом, продолжит двигаться вперед (пропуская его через имеющиеся узлы), пока не окажется в энергетической впадине, таким образом найдя ближайший шаблон в своей памяти.

Сеть Хопфилда можно использовать для воссоздания данных, содержащих шум или частично стертых.

Если думать об узлах как о пикселях на изображении, они могут иметь разные цвета, а не только черный или белый. Улучшенные методы сделали возможным сохранение большего количества изображений и различение их, даже если они довольно похожи. Точно так же возможно идентифицировать или реконструировать любую информацию, при условии, что она построена из многих точек данных.

Классификация с использованием физики девятнадцатого века

Запомнить изображение — это одно, но интерпретация того, что оно изображено, требует немного большего.

Даже очень маленькие дети могут указывать на разных животных и уверенно говорить, собака это, кошка или белка. Иногда они могут ошибаться, но довольно скоро будут правы почти всегда. Ребенок может научиться этому, даже не видя никаких схем или объяснений. После того, как он встретит несколько примеров каждого типа животных, различные категории встанут на свои места в голове ребенка автоматически.

Джеффри Хинтон изучал экспериментальную психологию и искусственный интеллект и задавался вопросом, могут ли машины научиться обрабатывать закономерности так же, как люди, находя свои собственные категории для сортировки и интерпретации информации. Хинтон расширил сеть Хопфилда, используя идеи из статистической физики.

Статистическая физика описывает системы, состоящие из множества схожих элементов, например, молекул в газе. Трудно или невозможно отследить все отдельные молекулы в газе, но можно рассматривать их вместе, чтобы определить общие свойства газа, такие как давление или температура. Есть много способов, которыми молекулы газа могут распространяться по его объему с индивидуальной скоростью и при этом по-прежнему иметь те же самые коллективные свойства. Некоторые состояния более вероятны, чем другие; это зависит от количества доступной энергии, которое описывается уравнением физика XIX века Людвига Больцмана. Сеть Хинтона использовала это уравнение, и метод был опубликован в 1985 году под ярким названием «машина Больцмана».

Распознавание новых примеров того же типа

В «машине Больцмана» обычно используется с двумя различными типами узлов. Информация подается в одну группу, которые называются видимыми узлами. Другие узлы образуют скрытый слой. Значения и связи скрытых узлов также вносят вклад в энергию сети в целом.

Машина работает, применяя правило обновления значений узлов по одному за раз. В конце концов машина перейдет в состояние, в котором вид узлов может измениться, но свойства сети в целом останутся прежними. Каждый возможный шаблон будет тогда иметь определенную вероятность, которая определяется энергией сети. Когда машина останавливается, она создает новый шаблон, что делает «машину Больцмана» одним из первых примеров генеративной модели.

«Машина Больцмана» может обучаться — не по инструкциям, а по полученным примерам. Она обучается путем обновления значений в связях сети, чтобы образцы примеров, которые были поданы на видимые узлы при обучении, имели максимально возможную «ценность». Если один и тот же образец повторяется несколько раз во время этого обучения, «ценность» для этого образца еще выше. Обучение влияет на вероятность вывода новых образцов, которые напоминают примеры, на которых обучалась машина.

Обученная «машина Больцмана» может распознавать знакомые черты в информации, которую она ранее не видела. Представьте себе встречу с братом или сестрой друга — аналогичным образом «машина Больцмана» может распознать совершенно новый пример, если он принадлежит к категории, имеющейся в ее учебном материале, и отличить от материала, который непохож на него.

В своей первоначальной форме «машина Больцмана» довольно неэффективна и требует много времени для поиска решений. В 1990-х годах многие исследователи потеряли интерес к искусственным нейронным сетям, но Хинтон был одним из тех, кто продолжал работать в этой области. В 2006 году он и его коллеги Саймон Осиндеро, Йи Уай Тэ и Руслан Салахутдинов разработали метод предварительного обучения сети с серией «машин Больцмана» в слоях, один над другим. Это оптимизировало обучение для распознавания элементов на изображениях.

«Машина Больцмана» часто используется как часть более крупной сети. Например, ее можно использовать для рекомендации фильмов или телесериалов на основе предпочтений зрителя.

Машинное обучение — сегодня и завтра

Благодаря своей работе, начатой в 1980-х годах, Джон Хопфилд и Джеффри Хинтон помогли заложить основу революции в области машинного обучения, которая началась примерно в 2010 году.

Развитие, свидетелями которого мы являемся сейчас, стало возможным благодаря доступу к огромным объемам данных, которые можно использовать для обучения сетей, а также благодаря колоссальному росту вычислительной мощности. Сегодняшние искусственные нейронные сети часто огромны и состоят из многих слоев. Они называются глубокими нейронными сетями, а способ их обучения называется глубоким обучением.

В статье об ассоциативной памяти от 1982 года Хопфилд использовал сеть с 30 узлами. Если все узлы соединены друг с другом, то получается 435 связей. Узлы имеют свои значения, связи имеют разную силу, и в общей сложности нужно отслеживать менее 500 параметров. Он также пробовал сеть со 100 узлами, но это было слишком сложно для компьютера того времени. Современные большие языковые модели, которые построены как сети, могут содержать более триллиона параметров (это миллион миллионов).

Машинное обучение уже давно используется в областях, с которыми мы, возможно, знакомы по предыдущим Нобелевским премиям по физике. Например, оно использовалось для просеивания и обработки огромных объемов данных, необходимых для открытия частицы Хиггса, для снижения шума при измерениях гравитационных волн от сталкивающихся черных дыр или поиска экзопланет и пр. В последние годы эта технология также начала использоваться при расчете и прогнозировании свойств молекул и материалов, например, при расчете структуры молекул белка, определяющей их функцию, или при определении того, какие новые версии материала могут обладать наилучшими свойствами в эффективных солнечных элементах.